深層強化学習は、強化学習と深層学習を組み合わせたAI技術であり、ゲームAIや自動運転、金融など幅広い分野で活用されている。本記事では、「深層強化学習と強化学習の違いは何ですか?」という疑問を解説し、DQN・A3C・RainbowといったアルゴリズムやPythonでの実装方法を紹介する。

また、深層学習の身近な例を交えながら、実社会での活用事例を解説し、「深層強化学習の弱点は何ですか?」という視点から課題も掘り下げる。深層強化学習の基礎から応用まで知りたい方は、ぜひ最後まで読んでいただきたいです。

この記事のポイント

- 深層強化学習の仕組みと強化学習との違い

- DQN・A3C・Rainbowなどの主要アルゴリズムの特徴

- Pythonを用いた深層強化学習の実装と活用方法

- ゲームAIや自動運転などの応用事例と課題

深層強化学習の基本と特徴

- 深層強化学習とはAIの何ですか?

- 深層強化学習と強化学習の違いは何ですか?

- 深層学習の身近な例は?

- 深層強化学習のアルゴリズムとは?

- 深層強化学習の弱点は何ですか?

- Atariゲームとは?

深層強化学習とはAIの何ですか?

深層強化学習とは、AI(人工知能)の中でも「学習と意思決定」の分野に属する技術です。具体的には、AIが試行錯誤を通じて最適な行動を自動的に学習する「強化学習」に、「深層学習(ディープラーニング)」を組み合わせた手法を指します。

通常、AIは与えられたデータからパターンを学習し、特定のルールに基づいて出力を生成します。しかし、深層強化学習ではAI自らがどのような行動が良い結果(報酬)につながるかを探索しながら学習を進めます。これにより人間がルールを細かく設定しなくても最適解を導き出すことができます。

例えば、囲碁や将棋、チェスといったボードゲームでは、従来のプログラムでは膨大なルールと戦略を人間が設計する必要がありました。しかし、深層強化学習を用いることで、AI自身が試行錯誤を繰り返しながら、強いプレイヤーと同等かそれ以上の戦略を発見できます。Google DeepMindの「AlphaGo」がその代表例です。

AlphaGoとは? Google DeepMindが開発した囲碁AIで、深層強化学習とモンテカルロ木探索を活用し、2016年にトップ棋士・李世乭九段に勝利した。

また、ロボットの制御や自動運転、金融取引の最適化など、現実世界の複雑な環境に適応するためにも活用されています。これらの分野では、環境が常に変化し、あらかじめ決められたルールでは対応しきれないケースが多いため、AIが自律的に適応できる深層強化学習が有効な手法となります。

一方で、深層強化学習には課題もあります。計算量が膨大になるため、高性能なコンピュータが必要であり、学習に時間がかかることが多いです。また、適切な報酬設計をしなければ、AIが意図しない行動を学習してしまう可能性もあります。そのため、研究者や開発者は、学習の安定性を向上させる技術や、より効率的な学習手法の開発を進めています。

深層強化学習と強化学習の違いは何ですか?

強化学習と深層強化学習は、どちらもAIが環境との相互作用を通じて最適な行動を学ぶ手法ですが、大きな違いは「学習の仕組み」と「扱える問題の複雑さ」にあります。

まず、強化学習は基本的に状態と行動の関係を数値データで管理し、Qテーブルと呼ばれるリストを使って行動の評価を蓄積します。このQテーブルは、各状態における行動の価値を明示的に保存することで、最適な行動を選択できるようになります。しかし、状態の数が増えるとテーブルのサイズが膨大になり、計算コストやメモリ使用量が増大するという課題があります。たとえば、シンプルな迷路のゲームならば強化学習でも問題ありませんが、囲碁や将棋、ロボットの制御など、状態の組み合わせが膨大となる場合、適用が難しくなります。

一方、深層強化学習は、強化学習に深層学習(ディープラーニング)を組み合わせた手法です。Qテーブルを使う代わりに、ニューラルネットワークを用いて状態と行動の関係を学習します。これにより、大量の状態を一括で学習し、未知の状態に対しても適切な行動を推測できる柔軟性を持ちます。例えば、DQN(Deep Q-Network)というアルゴリズムは、ニューラルネットワークを用いてQ値を推定し、テーブル管理の負担を軽減することで、高次元の環境でも適切な行動選択を可能にしました。

この違いから、強化学習は単純な環境に適しており、深層強化学習は複雑な環境に対応できるという特徴があります。例えば、ゲームAIやロボットの自律制御、金融市場の予測など、計算量が多く高度なパターン認識が求められる場面では、深層強化学習の方が有効です。

ただし前述しましたが、深層強化学習は大量のデータと計算資源を必要とするため、学習時間が長くなる点がデメリットとなります。また、ニューラルネットワークが適切なパターンを学習できない場合、行動が不安定になることもあるため、強化学習との使い分けが重要になります。

深層学習の身近な例は?

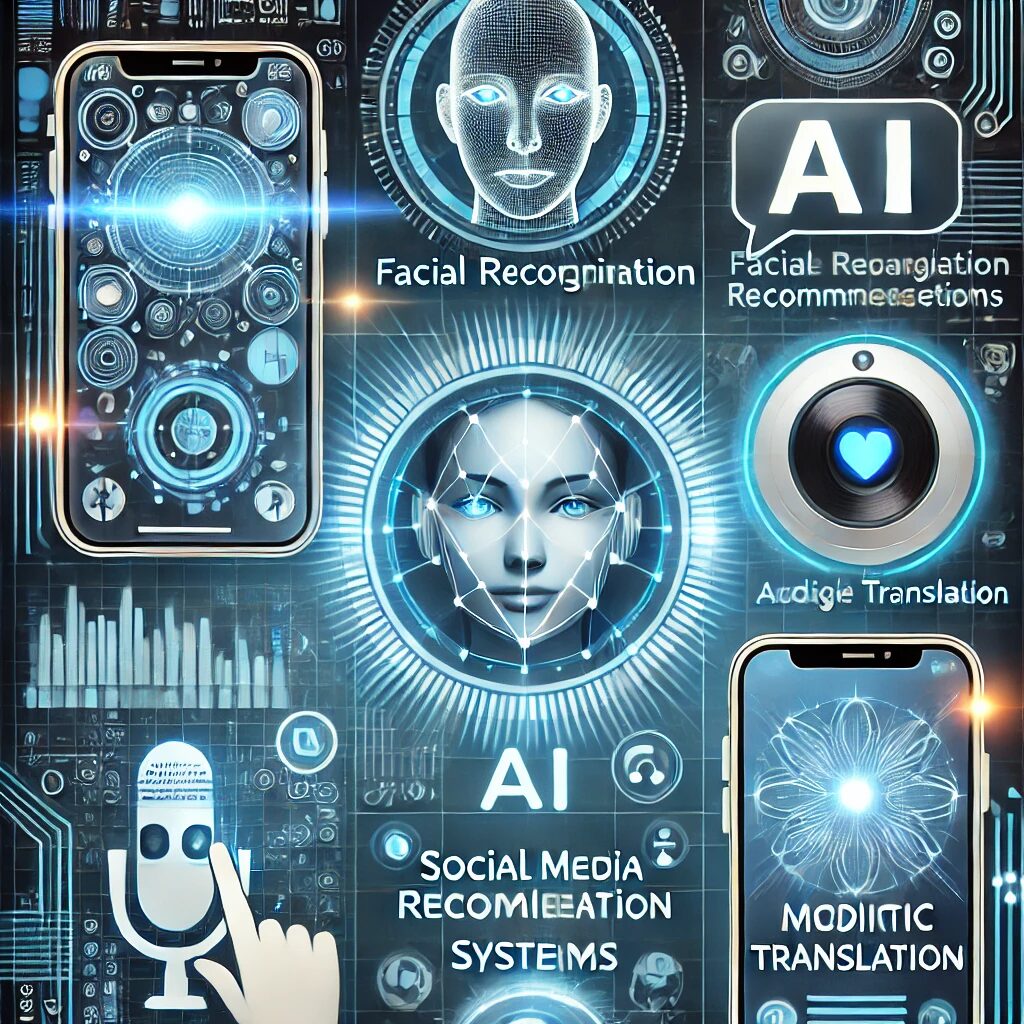

深層学習(ディープラーニング)は、人工知能(AI)の中でも特に注目されている技術であり、実は私たちの日常生活のさまざまな場面で活用されています。普段意識せずに利用している技術の多くが深層学習を基盤としており、その応用範囲は非常に広いです。

まず、スマートフォンの顔認証は代表的な例です。多くのスマートフォンには、顔認識を用いたロック解除機能がありますが、これは深層学習を活用した画像認識技術によって実現されています。カメラで撮影された画像をニューラルネットワークが解析し、登録された顔と一致するかを判定します。これにより、高精度な認証が可能になり、セキュリティの向上に貢献しています。

次に、音声アシスタントも深層学習の成果です。AppleのSiri、Googleアシスタント、AmazonのAlexaなどの音声アシスタントは、ディープラーニングを活用して音声データを解析し、自然な対話を可能にしています。これらのシステムは、発話内容を認識するだけでなく、文脈を理解し、適切な応答を生成するための高度な言語モデルを使用しています。日常のスケジュール管理や情報検索、家電の操作など、私たちの生活を便利にする技術の一つとなっています。

また、SNSや動画配信サービスのおすすめ機能にも深層学習が使われています。YouTube、Netflix、Spotifyなどのサービスは、ユーザーの過去の視聴履歴や行動パターンを解析し、好みに合ったコンテンツを推薦するアルゴリズムを採用しています。これは深層学習によってユーザーごとの嗜好を学習し、個別に最適化されたコンテンツを提供する仕組みです。これにより、視聴者は興味のある動画や音楽を効率的に見つけることができるようになっています。

さらに、自動翻訳も深層学習による技術革新の一例です。Google翻訳やDeepL翻訳は、従来の単語単位の翻訳ではなく、文章全体の意味を理解しながら自然な訳文を生成する能力を備えています。これは、ニューラルネットワークを活用することで、文脈を考慮した高精度な翻訳を可能にしているのです。

最後に、医療分野でも深層学習が活躍しています。例えば、CTやMRI画像を解析し、疾患の早期発見を支援するAI技術があります。これにより、医師の診断をサポートし、より迅速かつ正確な治療計画の立案が可能になります。また、がん細胞の検出や、患者の電子カルテデータをもとにした疾患予測などにも活用されています。

深層強化学習のアルゴリズムとは?

代表的なアルゴリズムとしてDQN(Deep Q-Network)があります。DQNは、Q学習(Q-learning)と呼ばれる強化学習の手法をディープラーニングで拡張したものです。従来のQ学習では、状態と行動の組み合わせをテーブル形式で管理していましたが、DQNではニューラルネットワークを利用してQ値を近似し、大規模な環境でも適用できるようになっています。DQNは、Google DeepMindが開発し、Atariゲームのプレイで人間のスコアを超える成績を達成したことで注目を集めました。

次に、A3C(Asynchronous Advantage Actor-Critic)は、強化学習の効率を向上させるために開発されたアルゴリズムです。従来の強化学習では、単一のエージェントが環境と相互作用しながら学習を行いますが、A3Cでは複数のエージェントが並行して異なる環境で学習を行い、その結果を統合します。これにより、学習の安定性が向上し、計算の効率が高まるというメリットがあります。

また、Rainbowというアルゴリズムも深層強化学習の分野で注目されています。Rainbowは、DQNの性能をさらに向上させるために、複数の技術(Dueling Network、Double Q-learning、Prioritized Experience Replay など)を組み合わせた手法です。これにより、単純なDQNよりも学習効率が向上し、より複雑な環境に適用しやすくなっています。

さらに、連続的な行動空間を扱う場合には、DDPG(Deep Deterministic Policy Gradient) や SAC(Soft Actor-Critic) などのアルゴリズムが用いられます。これらは、ロボット制御や自動運転などの分野で利用されており、DQNのように離散的な行動を学習するのではなく、連続的な制御を可能にするのが特徴です。特にSACは、探索と安定した学習を両立させるための工夫が施されており、より複雑なタスクにも対応可能です。

以上、深層強化学習にはさまざまなアルゴリズムがあり、ゲームAI、ロボット制御、自動運転、金融取引の最適化など、幅広い分野で活用されています。

深層強化学習の弱点は何ですか?

深層強化学習は、従来のAI技術では解決が難しかった問題を克服する可能性を持っていますが、学習の効率性、安定性、解釈の難しさ、報酬設計の複雑さなど、多くの課題も抱えています。特に実環境での適用には慎重な検討が必要であり、技術の発展とともに新たな解決策が求められています。

1. 学習に膨大な時間と計算リソースが必要

深層強化学習は試行錯誤を通じて最適な行動を学習するため、十分な性能を発揮するには大量のデータが必要です。例えば、AlphaGoのような高度な強化学習モデルでは、数百万回以上の対戦シミュレーションを行いながら学習を進めます。これは、一般的な教師あり学習と比べて学習プロセスが非常に非効率であり、大量の計算リソースを消費するという問題を引き起こします。

特に、GPUやTPUといった高性能なハードウェアを必要とするため、コストがかかる点も大きな課題です。実際、強化学習を用いた研究では、大規模なクラウド環境やスーパーコンピュータを利用することも珍しくありません。そのため、計算資源の制約がある環境では、深層強化学習の活用が難しくなります。

2. 学習の安定性が低く、最適解に到達しづらい

深層強化学習は、環境から得られる報酬をもとに行動を最適化しますが、学習の進行が不安定になりやすいという問題があります。特に、環境が複雑な場合や報酬の設計が適切でない場合、エージェント(AI)は間違った行動方針を学習してしまうことがあります。

例えば、あるタスクで「短期的な報酬を得る行動」を優先しすぎると、本来達成すべき「長期的な報酬の最大化」にはつながらないケースがあります。これは、「報酬スパースネス(Reward Sparsity)」と呼ばれる現象で、強化学習の課題の一つです。この問題を解決するためには、報酬設計を工夫する、探索戦略を改良する、学習データのバリエーションを増やすなどのアプローチが必要になります。

3. 学習結果の解釈が難しい

深層強化学習は、ディープニューラルネットワークを活用することで複雑なタスクの最適化を可能にしていますが、その学習プロセスや判断の根拠を理解するのが困難です。

例えば、囲碁AIのAlphaGoがなぜ特定の手を選んだのか、人間が明確に説明することは難しい場合がほとんどです。これは、一般的なディープラーニングの課題とも共通する点であり、特に、安全性が求められる分野(医療や自動運転など)では、AIの意思決定の透明性が求められるため、説明可能性(Explainability)を向上させる技術の開発が重要です。

4. 報酬設計が難しい

強化学習は、環境からの報酬を最大化するように行動を学習する仕組みですが、この報酬の設計が適切でないと、意図しない行動を学習してしまうリスクがあります。

例えば、ゲームAIがプレイヤーを打ち負かすことが目的である場合、勝利するだけではなく、試合を長引かせてより多くの報酬を得ようとする行動を取ることがあります。これは、AIが「勝利」ではなく「より多くの報酬を得る」ことを最優先に考えるためです。このような望ましくない行動を防ぐためには、慎重に報酬を設計し、AIが適切な目標を達成するよう誘導する必要があります。

5. 実環境での適用が難しい

深層強化学習は、ゲームやシミュレーション環境では優れた成果を示していますが、現実世界での応用には多くの課題があります。

例えば、自動運転の分野では、シミュレーション上ではうまく動作するAIでも、実際の道路環境では予測できない要素(歩行者の急な飛び出し、悪天候など)が多いため、正しく学習したモデルでも適切な対応ができない場合があります。また、ロボットの操作に深層強化学習を適用する場合、学習データを収集するために実際のロボットを動かす必要がありますが、物理的なコストや機器の損傷リスクが伴います。そのため、シミュレーションと実環境の差異を埋めるための転移学習(Transfer Learning)やシミュレーションの精度向上が求められています。

6. 倫理的・安全性の問題

深層強化学習は、適用する分野によっては倫理的な問題や安全性のリスクを伴うことがあります。

例えば、金融取引の最適化に活用される場合、AIが過剰なリスクを取るような戦略を学習してしまうと、大きな経済的損失を招く可能性があります。また、軍事用途に適用される場合、倫理的な問題が生じる可能性もあります。AIが自律的に意思決定を行う領域では、人間の監督が不可欠であり、安全性を確保するためのガイドラインや規制の整備が求められます。

Atariゲームとは?

Atariゲーム とは、1970年代から1980年代にかけて Atari社 によって開発・販売されたアーケードゲームおよび家庭用ゲーム機向けのゲームの総称です。特に、Atari 2600という家庭用ゲーム機が世界的にヒットし、ビデオゲームの普及に大きな影響を与えました。

現在では AI研究のテストベッド としても活用されています。シンプルなルールと多様なジャンルを持つため、強化学習エージェントの学習・評価に適した環境となっています。

Atariゲームの特徴

- シンプルなルール

- 画面のグラフィックはドットで構成され、基本的なゲームルールが中心。

- 「スコアを伸ばす」「敵を倒す」「障害物を避ける」など、直感的に遊べる設計。

- 2Dグラフィック

- 8ビットまたは16ビットの単純なドット絵が特徴。

- ゲーム内の動きもシンプルで、主に左右・上下の動きが中心。

- アーケードと家庭用ゲーム機の両方で展開

- 初期はアーケードゲームとして誕生し、後に家庭用ゲーム機(Atari 2600など)に移植。

代表的なAtariゲーム

- Pong(ポン, 1972年)世界初の大ヒットしたビデオゲーム。卓球を模したシンプルな対戦ゲーム。

- Breakout(ブロック崩し, 1976年)ボールをパドルで跳ね返し、上部のブロックを壊していくゲーム。

- Space Invaders(スペースインベーダー, 1978年)エイリアンを撃ち落とすシューティングゲーム。

- Pac-Man(パックマン, 1980年)迷路の中でドットを食べながらゴーストから逃げるゲーム。

- Asteroids(アステロイド, 1979年)隕石を避けながら撃ち落とす宇宙シューティングゲーム。

深層強化学習とAtariゲームの関係

近年、Atariゲームは深層強化学習(Deep Reinforcement Learning, DRL) の研究分野で重要な役割を果たしています。特に、DQN(Deep Q-Network) の登場により、強化学習エージェントが人間レベルでゲームをプレイできるようになりました。

- シンプルなルール → AIが学習しやすい。

- 多様なゲームジャンル → 汎用的な強化学習モデルの評価に適している。

- スコアの最大化が目的 → 報酬を明確に設定しやすい。

Google DeepMindが発表した論文では、DQNが複数のAtariゲームで 人間のプレイヤーを超えるスコアを記録 したことが話題になりました。

深層強化学習の活用と実装

- 深層強化学習とPythonの関係

- DQNとは?深層強化学習の代表モデル

- A3Cとは?分散学習の強化手法

- Rainbowとは?最新の強化学習手法

- 深層強化学習とゲームの関係

- 深層強化学習の未来と応用分野

深層強化学習とPythonの関係

1. Pythonが深層強化学習で利用される理由

Pythonは、シンプルな文法と強力なライブラリ群を備えており、機械学習やAI開発に最適な言語です。特に、深層強化学習では大量のデータを処理し、複雑な数学的計算を行う必要がありますが、Pythonは以下のような点で優れた特性を持っています。

- ライブラリの充実

深層強化学習の開発には、NumPyやPandasといったデータ処理ライブラリ、TensorFlowやPyTorchなどの深層学習ライブラリが不可欠です。また、OpenAI Gymのようなシミュレーション環境を提供するライブラリもあり、強化学習の実験が簡単に行えます。 - 数値計算や行列演算の最適化

深層強化学習では、ニューラルネットワークの訓練時に大量の行列演算が発生します。PythonのNumPyやCuPyを活用すれば、高速なベクトル計算が可能になります。 - 開発のしやすさとコミュニティの強さ

Pythonはオープンソースであり、世界中の研究者や開発者が利用しています。豊富なドキュメントやサンプルコードが存在するため、初心者でも比較的簡単に深層強化学習を学ぶことができます。

2. 深層強化学習に活用されるPythonライブラリ

Pythonには、深層強化学習の開発に適した多くのライブラリが存在します。ここでは代表的なものを紹介します。

- TensorFlow/Keras

Googleが開発したディープラーニングフレームワークであり、ニューラルネットワークの構築や訓練が容易に行えます。強化学習のアルゴリズムも実装可能です。 - PyTorch

動的な計算グラフを用いた柔軟なディープラーニングライブラリで、研究用途で特に人気があります。深層強化学習のアルゴリズムを実装する際にも便利です。 - OpenAI Gym

強化学習の学習環境を提供するライブラリで、さまざまなシミュレーション環境(ゲームやロボット制御など)を利用できます。 - Stable Baselines3

事前に実装された強化学習アルゴリズムのライブラリで、DQN、A3C、PPOなどのモデルがすぐに利用できます。

3. Pythonを使った深層強化学習の基本的な流れ

実際にPythonを使って深層強化学習を実装する場合、一般的な流れは以下のようになります。

- 環境の準備

OpenAI Gymなどを使って強化学習の環境を設定します。 - ニューラルネットワークの構築

TensorFlowやPyTorchを用いて、状態を入力し、行動を出力するモデルを作成します。 - 報酬と行動の定義

環境内でエージェントがどのように学習するかを決めます。 - 学習の実行

強化学習のアルゴリズムを適用し、エージェントが報酬を最大化できるようにモデルを更新します。 - モデルの評価

学習したエージェントのパフォーマンスをテストし、必要に応じて調整します。

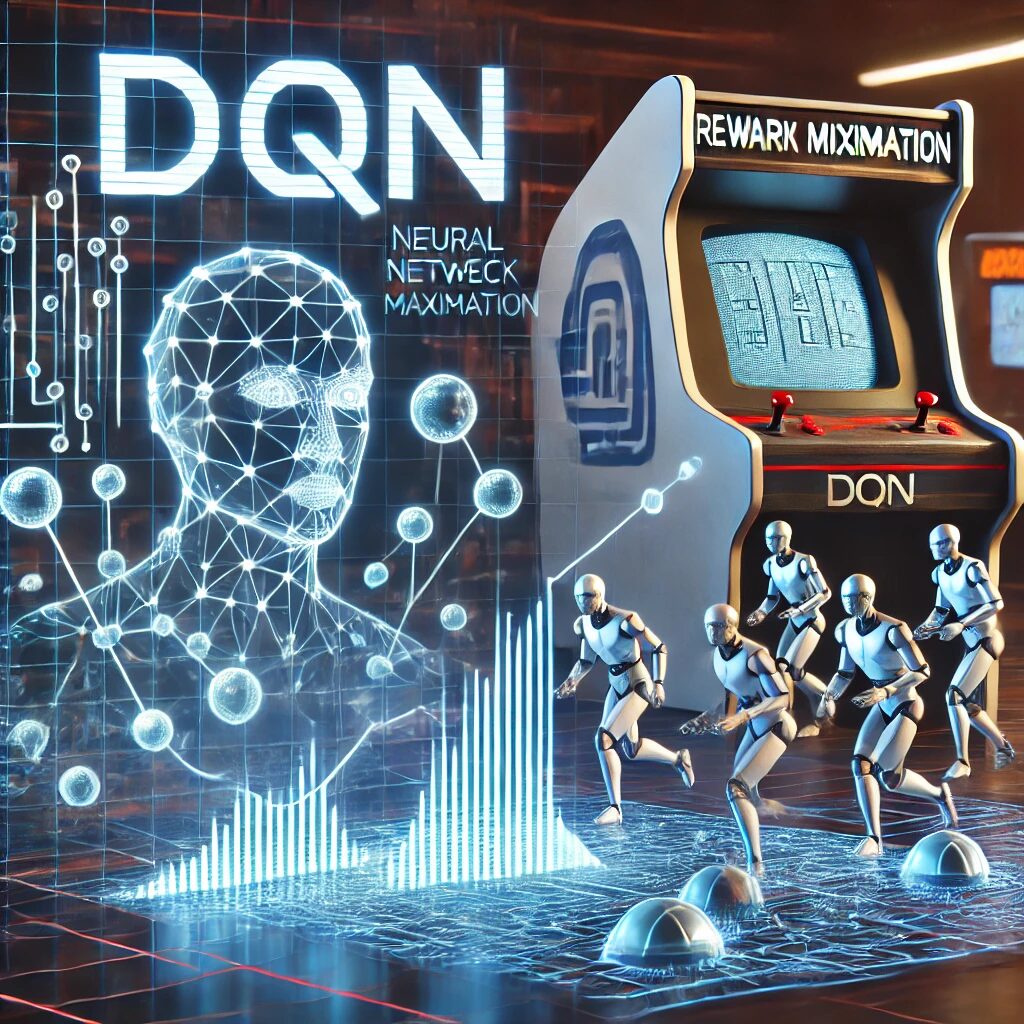

DQNとは?深層強化学習の代表モデル

DQN(Deep Q-Network)は、深層強化学習の代表的なアルゴリズムの一つであり、Google DeepMindが2015年に発表したモデルです。従来の強化学習とディープラーニングを組み合わせることで、より高度な意思決定を可能にしました。

1. DQNの基本概念

DQNは、強化学習の代表的な手法であるQ学習(Q-Learning)にディープニューラルネットワークを組み合わせたアルゴリズムです。Q学習は、各状態における最適な行動を決定するために「Q関数」を用います。しかし、状態空間が大きくなると、すべての状態をテーブルで管理することが困難になります。そこで、DQNではニューラルネットワークを用いてQ関数を近似し、より大規模な環境にも適用できるようになりました。

2. DQNの特徴

DQNには、強化学習の学習効率を向上させるためのいくつかの工夫が施されています。

- 経験再生(Experience Replay)

エージェントが環境で得た経験をリプレイメモリに保存し、ランダムにサンプリングして学習することで、データの相関を低減し、学習の安定性を向上させます。 - ターゲットネットワークの導入

Q関数の更新時に、学習中のネットワークとは別にターゲットネットワークを用意し、一定の間隔で更新することで、学習の安定性を確保します。 - 報酬の正規化(Clipped Rewards)

ゲームなどで報酬が極端に変化することを防ぐため、報酬の範囲を一定に制限します。

3. DQNの応用例

DQNは、特にゲームAIの分野で大きな成果を上げました。たとえば、Atari2600のビデオゲームをプレイするAIの開発では、DQNを用いることで、人間のプレイヤーを超える成績を収めることができました。これは、単純なピクセル情報を入力として、ゲームの操作を学習することができる点で画期的でした。

また、DQNはゲーム以外にも、自動運転の意思決定やロボット制御、金融取引の最適化など、さまざまな分野で応用されています。

4. DQNの課題と改良

DQNにはいくつかの課題があり、その後の研究によって改良が進められています。

- 学習が不安定になりやすい → Double DQNを導入し、学習の安定性を向上

- 過学習のリスクがある → Dueling DQNで報酬予測と行動選択を分離

- サンプル効率が低い → Prioritized Experience Replayにより、重要な経験を優先的に学習

DQNは、深層強化学習の基礎を築いた重要なアルゴリズムであり、その改良版が次々と登場しています。これにより、より複雑なタスクへの適用が可能になっています。

A3Cとは?分散学習の強化手法

A3C(Asynchronous Advantage Actor-Critic)は、Google DeepMindが提案した強化学習のアルゴリズムであり、特に分散学習に適した手法です。従来の強化学習アルゴリズムは、一つのエージェントが順番に環境と相互作用しながら学習する形式が主流でした。しかし、A3Cは複数のエージェントが並行して学習することで、効率的な学習を可能にしました。

1. A3Cの特徴

A3Cの最大の特徴は「非同期型の並列学習」です。従来の強化学習では、一つのエージェントが環境と相互作用しながらQ関数や方策を更新していくため、計算資源を最大限に活用しにくいという課題がありました。しかし、A3Cでは複数のエージェント(ワーカー)が同時に環境で学習し、それぞれが得た経験を中央のネットワークに共有する形で学習を進めます。これにより、探索の多様性が向上し、学習のスピードが大幅に向上します。

また、A3Cでは「アクター・クリティック(Actor-Critic)」と呼ばれる手法を採用しています。これは、方策(Policy)を決定するアクター(Actor)と、行動の価値を評価するクリティック(Critic)の二つのネットワークを組み合わせた手法です。アクターは環境からの観測に基づき行動を選択し、クリティックはその行動がどの程度有益だったかを評価する役割を持っています。これにより、方策の学習と価値関数の学習を並行して行うことができます。

2. A3Cの利点

A3Cの利点として、以下の3点が挙げられます。

- 学習の高速化

複数のワーカーが並行して学習を行うことで、1つのエージェントが順番に学習する手法よりも効率的に学習が進みます。 - 探索の多様性が向上

複数のエージェントが異なる環境状態で学習を行うため、局所的な最適解に陥りにくく、より良い方策を見つけやすくなります。 - 安定した学習が可能

クリティックによる価値評価が方策の更新を安定化させ、効率的な学習を実現します。

3. A3Cの応用例

A3Cは、ゲームAI、ロボット制御、金融市場の最適化など、リアルタイムでの意思決定が求められるさまざまな分野で活用されています。特に、Atariゲームの学習ではDQNよりも少ないサンプルで高いパフォーマンスを発揮したことが報告されています。

4. A3Cの課題

- 非同期によるデータのばらつき

ワーカーごとに異なる環境状態で学習するため、収集されるデータにばらつきが生じることがあります。 - 計算資源の必要性

並列処理を行うため、複数のCPUやGPUが必要となり、単一のエージェントを用いた学習に比べて計算コストが高くなります。

こうした課題に対応するため、A3Cを改良したA2C(Advantage Actor-Critic)と呼ばれる手法も開発されており、より安定した学習が可能になっています。

Rainbowとは?最新の強化学習手法

Rainbowは、Deep Q-Network(DQN)を改良した強化学習のアルゴリズムであり、複数の強化学習の手法を組み合わせることで、より強力なモデルを実現したものです。DQNは、Atariゲームの学習などで画期的な成果を上げましたが、学習の安定性やサンプル効率に関する課題がありました。Rainbowはこれらの課題を克服し、より優れたパフォーマンスを実現しています。

1. Rainbowの特徴

以下の6つの技術を組み合わせています。

- Double DQN(DDQN)

DQNの学習では、ターゲットQ値のバイアスが生じやすいという問題がありました。DDQNでは、Q値の更新時に2つのネットワークを用いることで、過大評価の問題を解決します。 - Dueling Network Architecture

状態の価値と行動ごとの価値を分離して学習することで、より効果的な学習を可能にします。これにより、行動価値の評価をより適切に行うことができます。 - Prioritized Experience Replay

従来のDQNでは経験リプレイにランダムサンプリングを用いていましたが、Rainbowでは重要な経験を優先的に学習することで、学習の効率を向上させています。 - Multi-step Learning

通常のQ学習では1ステップ後の報酬を学習に利用しますが、複数ステップ先の報酬を考慮することで、より良い方策を学習できるようになります。 - Noisy Networks

探索と利用のバランスを自動調整するために、ネットワークのパラメータにノイズを加える手法です。これにより、ε-greedy法のようなハイパーパラメータ調整が不要になります。 - Categorical DQN(C51)

Q値を確率分布として扱い、より細かい価値の推定を行うことで、学習の安定性を向上させます。

2. Rainbowの利点

Rainbowの最大の利点は、上記の複数の手法を統合することで、DQN単体よりも学習の安定性が高く、サンプル効率が向上している点です。これにより、少ない試行回数でより良い方策を見つけることが可能になります。

3. Rainbowの応用例

Rainbowは、Atariゲームの学習で高いパフォーマンスを示したことで有名ですが、他にもロボット制御や金融市場のシミュレーションなど、さまざまな領域で応用が進められています。特に、探索が重要な問題において、Noisy Networksによる自動探索調整が有効に機能します。

4. Rainbowの課題

RainbowはDQNの改良版として優れた性能を発揮しますが、以下の課題もあります。

- 計算コストが高い

6つの手法を統合しているため、単純なDQNに比べて計算量が増加し、学習時間が長くなることがあります。 - ハイパーパラメータの調整が難しい

複数の技術を組み合わせているため、最適な設定を見つけるには多くの試行錯誤が必要になります。

それでも、Rainbowは最新の強化学習手法として、高いパフォーマンスを誇るアルゴリズムであり、今後もさらなる改良が期待されています。

深層強化学習とゲームの関係

深層強化学習がゲームと深く関わる理由は、強化学習が試行錯誤による最適化を得意とし、ゲームという仮想環境の中で繰り返し学習できるためです。

1. ゲームAIの進化

従来のゲームAIは、開発者があらかじめルールや戦略をプログラムする「ルールベースAI」が主流でした。しかし、深層強化学習を活用すれば、AIはプレイヤーと対戦を繰り返しながら自ら学習し、最適な戦略を獲得できます。たとえば、前述した囲碁の「AlphaGo」は、自己対戦を重ねながら学習し、世界トップレベルの棋士を破るほどの実力を身につけました。

また、アクションゲームやシミュレーションゲームでも、AIがプレイヤーの行動パターンを学び、より人間らしい動きをすることが可能になります。これにより、より挑戦的でリアルな対戦が実現し、ゲームの楽しさが向上します。

2. ゲームバランスの調整

対戦型ゲームでは、キャラクターの強さや武器の性能が極端に偏ると、プレイヤー間の公平性が損なわれます。深層強化学習を用いたシミュレーションを実施することで、さまざまなパターンの戦闘をAIが繰り返しプレイし、バランスの取れたゲーム環境を設計することができます。

たとえば、あるキャラクターが強すぎる場合、AIを使って勝率の偏りを分析し、そのキャラクターの能力を適切に調整することが可能です。これにより、プレイヤーが公平な競技環境でゲームを楽しめるようになります。

3. 自動プレイと難易度調整

一部のゲームでは、AIがプレイヤーの行動を学習し、プレイヤーのスキルレベルに応じて適切な難易度を提供する機能が導入されています。例えば、FPSゲームでは、初心者にはやさしく、上級者にはより高度な戦略で挑んでくる敵AIを作ることにより、プレイヤーのスキルに合ったゲームを楽しむことができます。

FPS(First-Person Shooter) ゲームとは一人称視点のシューティングゲーム で、プレイヤーはゲーム内のキャラクターの視点で操作し、銃やその他の武器を使用して戦闘を行うゲームです。

また、プレイヤーがAIの自動プレイ機能を活用することで、効率的な攻略法を学ぶことも可能になります。最近では、モバイルゲームなどでAIが自動的に戦闘を行う「オートバトル機能」が搭載されており、深層強化学習を応用した戦略的なAIが活用されています。

4. 新たなゲームプレイの創出

深層強化学習の進化により、ゲームのプレイスタイルそのものが変わる可能性もあります。

- プレイヤーの行動によってダイナミックにゲームのストーリーやマップが変化するAI駆動型のゲーム

- プレイヤーがAIと協力しながら進めるゲーム

深層強化学習の未来と応用分野

深層強化学習は、より複雑な問題解決や最適化が可能になり、私たちの生活や産業に大きな影響を与えるものになりそうです。例をいくつかご紹介いたします。

1. 自動運転と交通システム

自動運転技術の発展において、AIが交通状況や周囲の車両の動きを学習し、より安全で効率的な運転を実現できるようになります。また、渋滞を回避する最適なルート選択や、事故を防ぐための判断を行うAIも開発されています。

さらに、公共交通機関の運行最適化にも応用される可能性があります。例えば、バスや電車の運行スケジュールをAIが調整し、乗客の流れを最適化することで、交通の効率化が進むと考えられます。

2. 医療分野での応用

医療分野においてAIが患者の病歴や検査データを学習し、最適な治療法を提案するシステムが開発され、医師の診断を補足することにより、よりスピーディかつ正確な治療方針を決定することが可能になります。

また、新薬の開発にも活用されており、膨大な化合物の組み合わせをAIがシミュレーションし、有効な薬を短期間で発見する技術も進化しています。これにより、従来の手法では時間がかかる新薬開発のプロセスが大幅に短縮される可能性があります。

3. 金融市場と経済予測

金融業界では、深層強化学習を活用したアルゴリズム取引が急速に進化しています。AIが市場データを分析し、最適な投資判断をリアルタイムで行うことで、リスクを最小限に抑えながら利益を最大化することが可能になります。

4. 環境問題とエネルギー最適化

エネルギー・環境分野では以下のスマートグリッドの管理に活用されています。将来的には気候変動対策にも応用が期待されており、環境データをもとに最適なCO2排出削減策を導き出す技術も進化しています。

スマートグリッド(Smart Grid) とは、電力の供給と消費を最適化するために、IT技術を活用した次世代の電力網のこと

スマートグリッド(Smart Grid) の特徴

- 双方向の電力管理 発電所からの一方的な供給ではなく、家庭や企業の電力使用状況をリアルタイムで把握し、必要な分のみ電力供給を行う。

- 再生可能エネルギーとの連携 太陽光発電や風力発電などの不安定な再生可能エネルギー を、蓄電技術やAIを活用して安定供給する。

- 電力の需給調整 ピーク時の電力消費を抑えるために、スマートメーターを用いて需要を調整する。

5. 教育と人材育成

教育分野においては学習者の理解度を分析し、個々に最適な学習プランを提供する「AIチューター」が開発されつつあります。これにより、より効果的な学習支援が可能となり、教育の質が向上することが期待されています。

総括:深層強化学習の概要と重要ポイント

記事のまとめ

- 深層強化学習は、強化学習と深層学習を組み合わせた手法

- 深層強化学習は、AIが試行錯誤を通じて最適な行動を学習する技術

- 強化学習との違いは、ニューラルネットワークを活用する点

- ゲームAIやロボット、自動運転など多様な分野で応用される

- 計算コストが高く、学習に膨大な時間を要する課題がある

- Atariゲームは深層強化学習の研究に利用される代表的な環境

- Pythonは深層強化学習の開発に最適なプログラミング言語

- DQNはQ学習を拡張した代表的な深層強化学習アルゴリズム

- A3Cは並列学習を活用し、学習の効率を向上させる手法

- Rainbowは複数の強化学習技術を統合した高度な手法

- ゲーム業界ではAIの強化学習がプレイヤーの体験を向上させる

- 金融や医療、自動運転など、さまざまな産業での活用が進む

- 報酬設計の難しさが学習の成功を左右する重要な要素となる

- スマートグリッドなどのエネルギー管理分野にも応用される

- 説明可能性の向上が今後の研究課題の一つとなっている